一、引言

Apache Spark是一种强大的大数据处理框架,它可以用于处理海量数据并快速提供结果。

本文将详细介绍如何安装与配置Spark开发环境,以S7-200程序为例,帮助读者顺利搭建Spark开发环境。

二、系统环境准备

在开始安装与配置Spark之前,我们需要先准备好所需的系统环境。以下是基本的准备工作:

1. 操作系统:支持Windows、Linux等操作系统。

2. Java环境:确保已安装Java JDK,并且配置好了JAVA_HOME环境变量。

3. Python环境:安装Python并配置环境变量,以便能够运行Python程序。还需要安装一些常用的Python库,如numpy、pandas等。

三、安装Spark

接下来,我们将介绍如何安装Spark。以下是详细的步骤:

1. 下载Spark安装包:访问Apache Spark官网,下载最新版本的Spark安装包。

2. 解压安装包:将下载的安装包解压到指定的目录。

3. 配置环境变量:在系统环境变量中添加Spark的安装路径,以便在命令行中直接运行Spark相关命令。

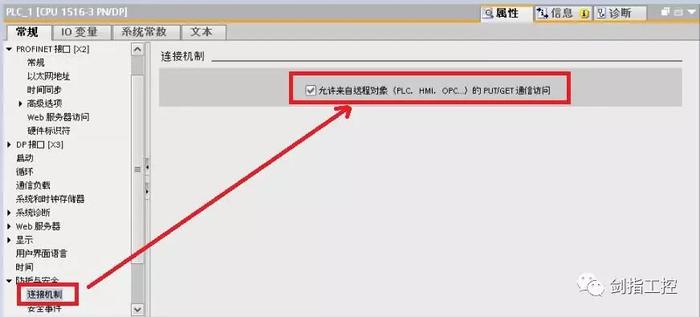

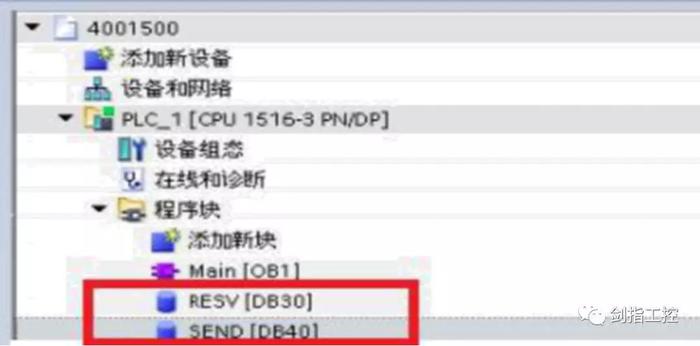

四、配置S7-200程序

为了使用Spark进行开发,我们需要配置S7-200程序。以下是详细的配置步骤:

1. 下载S7-200程序:访问相关网站下载最新版本的S7-200程序安装包

2. 安装S7-200程序:将下载的安装包进行安装,选择默认设置即可。

3. 配置S7-200与Spark的关联:在S7-200程序的配置中,需要设置Spark的相关参数,以便将S7-200程序与Spark集成。具体的配置参数包括Spark的主机名、端口号等。

五、详细安装与配置步骤

接下来,我们将详细介绍如何安装与配置Spark开发环境:

1. 下载并安装Java JDK:访问Oracle官网或其他可信的Java下载网站,下载并安装最新版本的Java JDK。

2. 配置Java环境变量:在系统环境变量中设置JAVA_HOME,并添加Java的bin目录到PATH环境变量中。

3. 下载并安装Python:访问Python官网,下载并安装最新版本的Python。

4. 安装Python库:在Python环境中,使用pip命令安装常用的Python库,如numpy、pandas等。

5. 下载并安装Spark:访问Apache Spark官网,下载最新版本的Spark安装包,并按照官方文档进行安装。

6. 配置Spark环境变量:在系统环境变量中添加Spark的安装路径。

7. 下载并安装S7-200程序:访问相关网站下载最新版本的S7-200程序安装包,并按照默认设置进行安装。

8. 配置S7-200与Spark的关联:在S7-200程序的配置中,设置Spark的相关参数,完成S7-200与Spark的集成。

9. 验证安装与配置:运行一个简单的Spark程序,验证是否成功安装与配置。

六、常见问题及解决方案

在安装与配置过程中,可能会遇到一些常见问题。以下是常见问题及其解决方案:

1. 问题:Java JDK安装失败。

解决方案:确保下载的Java JDK安装包完整且没有损坏,重新下载并安装。

2. 问题:Python库安装失败。

解决方案:使用pip命令重新安装库,或者尝试使用其他版本的Python。

3. 问题:Spark无法正常运行。

解决方案:检查Spark的配置是否正确,确保Java环境已经正确配置。还可以查看Spark的日志文件,以获取更多错误信息。

七、总结

本文详细介绍了如何安装与配置Spark开发环境,并以S7-200程序为例进行了说明。

通过遵循本文的步骤,读者可以顺利搭建Spark开发环境,并进行相关的开发工作。

希望本文能对读者有所帮助。

本文原创来源:电气TV网,欢迎收藏本网址,收藏不迷路哦!

添加新评论